Sedan Storage Spaces introducerades i Windows Server 2012 så har Microsofts väg mot hyperkonvergerade lösningar varit något vi följt väldigt noga. Företag som VMware och Nutanix var tidigt ute men nu har Microsoft en lösning framme som på allvar kan konkurrera med dessa.

I den här artikeln reder vi ut begreppen och pekar på vad som är nytt och ser fram emot att skriva mer om våra tidigare erfarenheter av Storage Spaces Direct och nya med Azure Stack HCI.

I slutet av mars 2019 annonserade Microsoft Azure Stack HCI som i praktiken är ett nytt namn för Storage Spaces Direct (S2D) eller det bredare begreppet Windows Server Software Defined Program. Kanske är namnbytet mest marknadsföring men det signalerar ändå en hel del om hur Microsoft vill positionera sina produkter.

Jag resonerar så här:

Microsoft lanserar många nya och bra funktioner inom ramen för Windows Server och på grund av detta kanske det här med hyperkonvergerade lösningar hamnar lite i skymundan. Windows Server anses ju av många vara ett traditionellt operativsystem som i första hand används för att drifta de nödvändiga infrastrukturtjänsterna och traditionella klient-server applikationer. Inte lika många ser Windows Server som en plattform för hyperkonvergerad infrastruktur eller hybrida moln.

Hittills har Microsofts lösning på molnbaserade lösningar varit Azure Stack. Något som på papperet är kanon men i praktiken en stor och dyr apparat. Jag tror att Azure Stack tilltalar större företag med en tydligt uttalad “cloud first” eller “cloud only” strategi. Hoppet från traditionell Hyper-V till Azure Stack innebär också en stor förändring eftersom Azure Stack innebär konsumtion av tjänster enligt de principer vi känner igen från publika moln. Det är här Azure Stack HCI kommer in och fyller tomrummet mellan Hyper-V och Azure Stack.

Förutom att vara en mjukvarudefinierad lagringslösning för Windows Server så är Azure Stack HCI mer av en nyckelfärdig lösning för hyperkonvergerad infrastruktur med en ansenlig mängd funktioner för hybrida moln. Fokuset är på traditionella virtuella maskiner och inte applikationer och tjänster som generellt återfinns i publika moln byggda på Azure Stack.

Azure Stack HCI låter dig köra virtuella maskiner on-premise ovanpå en infrastruktur som består av Windows Server, Hyper-V, Storage Spaces Direct och hanteras i nya Windows Admin Center.

Du köper hårdvaran i form av godkända konfigurationer från certifierade tillverkare, t.ex. Dell, HPE, Supermicro m.fl. Förutom godkända konfigurationer skall detta också innebära support på hela lösningen (alltså hw + sw) från en och samma kontakt, tillverkaren i det här fallet.

Det här är en av de stora skillnaderna med Azure Stack och Azure Stack HCI, i fallet med HCI är konfigurationen av hårdvaran mer flexibel och du får ändra på den. Medans Azure Stack kommer i mindre dynamiska block. Du har också tillgång och kontroll över de underliggande komponenterna Windows Server, Hyper-V och S2D, vilket du inte har i Azure Stack.

Om vi lyfter blicken ovanför infrastrukturen och tittar på tjänsterna så skiljer sig Azure Stack och Azure Stack HCI väsentligt. Azure Stack HCI erbjuder inte samma möjligheter att driftsätta applikationer och tjänster on-premise på samma sätt som Azure Stack. I stället erbjuder Azure Stack HCI integrationer med Azure i form av:

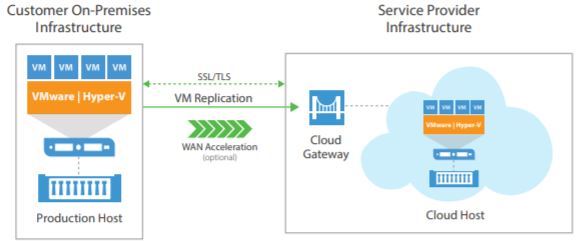

• Azure Site Recovery for high availability and disaster recovery as a service (DRaaS).

• Azure Monitor, a centralized hub to track what’s happening across your applications, network, and infrastructure – with advanced analytics powered by AI.

• Cloud Witness, to use Azure as the lightweight tie breaker for cluster quorum.

• Azure Backup for offsite data protection and to protect against ransomware.

• Azure Update Management for update assessment and update deployments for Windows VMs running in Azure and on-premises.

• Azure Network Adapter to connect resources on-premises with your VMs in Azure via a point-to-site VPN.

• Azure Security Center for threat detection and monitoring for VMs running in Azure and on-premises (coming soon).

Nyheter inom Storage Spaces Direct för Windows Server 2019 är följande, vilket vi då också återspeglas i Azure Stack HCI:

• Deduplication and compression for ReFS volumes

• Native support for persistent memory

• Nested resiliency for two-node hyper-converged infrastructure at the edge

• Two-server clusters using a USB flash drive as a witness

• Performance history

• Scale up to 4 PB per cluster

• Mirror-accelerated parity is 2X faster

• Drive latency outlier detection

• Manually delimit the allocation of volumes to increase fault tolerance

De nyheter vi tycker är mest spännande är deduplicering och komprimering för ReFS samt två noders kluster. Båda dessa funktioner bidrar till lägre investeringskostnader. Att kunna bygga ett cluster med bara två noder passar mindre företag som har en stor andel traditionella applikationer och virtuella maskiner perfekt. Prisbilden blir riktigt intressant samtidigt som prestandan brukar räcka till med marginal.

Sammanfattningsvis tycker vi att det är kanon att Microsoft numera har en paketerad lösning för hyperkonvergerade infrastruktur. Dessutom kan vi lita på att hårdvarutillverkarna har gjort en del av arbetet och tar ansvar för att komponenterna skall lira ihop.

Men framförallt är detta en lösning där vi kan få riktigt grym prestanda och kapacitet till ett lågt pris i vårt lokala datacenter och sedan nyttja Azure för backup och katastrofsäkring.